Myanmar: Un genocidio patrocinado por Facebook

Artículo basado en el libro: "Los Irresponsables: Una historia real de poder, codicia y falso idealismo" de Sarah Wynn-Williams.

12 min read

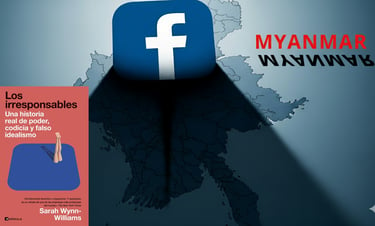

“No solo nos tratamos mal entre nosotros en las oficinas centrales, sino que también estamos haciendo daño de verdad al mundo”. Estas palabras son de Sarah Wynn-Williams, directora de Políticas Públicas de Meta (empresa matriz de Facebook) entre los años 2011 y 2017, y autora del libro en el que se basa este artículo. En otro artículo ya habíamos explicado el potencial que tiene Facebook para organizar un genocidio gracias a la enorme rapidez con la que se difunden los mensajes de odio mediante su algoritmo. En este caso, por el contrario, analizaremos la misma situación pero esta vez desde la perspectiva de una trabajadora de relevancia en Facebook.

Myanmar (antes Birmania) ejemplifica de forma evidente el daño que puede generar Facebook en un país. Gracias al proyecto personal de Mark Zuckerberg, internet.org, la población de Myanmar pasó de prácticamente no tener Internet, a que casi todos los habitantes tuvieran móvil, saltándose el paso de los ordenadores de sobremesa, y todo en un periodo de 4 años (2013-2017). Y en estos móviles, internet, para casi todo el mundo en Myanmar, quiere decir Facebook. Gracias a los acuerdos que la plataforma estableció con las operadoras telefónicas locales, Facebook aparecía preinstalado en los dispositivos, y en la mayoría de planes de telefonía contratados, el tiempo que pasabas en Facebook no aparecía en el consumo de datos. Por lo tanto, en Myanmar, tener internet significaba estar en Facebook, y por este motivo, Myanmar es la demostración palpable de los catastróficos estragos que puede causar la plataforma cuando representa la verdad omnipresente.

En abril de 2014, por Myanmar corría un violento discurso de odio. La mayoría se dirigía contra la minoría musulmana del país, los rohinyás. Las turbas ya habían empezado a quemar mezquitas y perseguir a sus feligreses. Como Facebook estaba siendo el vehículo que movilizaba y congregaba ese odio, los responsables de políticas públicas (como Sarah) contactaron con el equipo de contenidos responsable de eliminar los discursos de odio, y les preguntaron si podían hacer algo para solucionarlo, la respuesta fue negativa. Acababan de contratar a un nuevo trabajador externo birmano para gestionar este asunto, y el responsable de políticas de contenidos afirmó que estaba todo controlado: “Puedo confirmar que nuestro representante birmano está muy capacitado”. El equipo de Sarah exigió un informe en el que se mostraba que solo había unas 4 o 5 denuncias por incitación al odio en la cola, lo que en el caso del masivo Facebook, no es nada. Unos meses después, varios disturbios se desencadenaron por Myanmar a raíz de una serie de publicaciones en Facebook, y como medida preventiva, la junta militar que por entonces gobernaba el país decidió bloquear la plataforma el 4 de julio de 2014. Una de las publicaciones incendiarias aseguraba que una mujer budista había sido violada por un musulmán que regentaba una tetaría. Más adelante, las Naciones Unidas llegaron a la conclusión de que esa teoría era falsa. Aun así, la publicación se hizo viral después de que la compartiera Ashin Wirathu, un monje budista al que a menudo se ha descrito como el “Bin Laden birmano”. Wirathu ya había pasado por la cárcel por incitar al odio por motivos religiosos y estaba empezando a descubrir cómo instrumentalizar Facebook.

Ashin Wirathu, monje budista también conocido como el "Bin Laden birmano" (Fuente: BBC)

Sarah recibió un email de la junta militar en el que indicaba que querían eliminar las publicaciones de Wirathu sobre la presunta violación. Estos mensajes estaban provocando violencia real: multitud de negocios destruidos, decenas de musulmanes muertos… Sin embargo, el equipo de operaciones de contenidos de Facebook, con sede en Dublín, se negó a eliminar las publicaciones falsas. Los responsables no creían que la publicaciones infringían las normas, pero en el equipo no había nadie que hablase birmano, y Google Translate no traducía del birmano, con lo que su afirmación no era más que una suposición ya que no sabían lo que se estaba publicando. Ante semejante disparate, Sarah tuvo que recurrir a un superior para que se pusiera en contacto con el nuevo trabajador externo de origen birmano, pero que vivía en Dublín. Pasaron más de 5 horas hasta que tuvo una respuesta, pero no del trabajador birmano, sino del superior con el que había contactado. “¿Cuánto crees que tardará?” preguntó angustiada Sarah mientras los disturbios se sucedían en las calles. “Me temo que no lo sé. No está conectado. Le he mencionado en Facebook y espero que lo vea y se ponga en contacto conmigo” respondió el superior. “¿Tienes su número de teléfono? Esto es una emergencia”. Tras contactar con el “presunto” trabajador, este le indicó que estaba en un restaurante y que en 15 minutos debería estar en un ordenador revisando las publicaciones y decidiendo si actuaba o no. Tras 2 horas de desesperante espera, el superior de Sarah le confirmó que ni él, ni el trabajador birmano estaban en la oficina, pero que se pondrían con ello en cuanto llegaran a casa. “¿Cuándo estarás en posición de hacerlo? Tenemos que actuar lo antes posible” insistió Sarah. Sin embargo, no obtuvo respuesta, por lo que Sarah trató de que alguien en la sede central (California) eliminara las incendiarias publicaciones. Al final, gracias al trabajo conjunto de los ingenieros de Dublín y de California, las publicaciones fueron borradas. 4 minutos después, Facebook fue desbloqueado en Myanmar, y eso que eran las 4:30 de la madrugada. Una junta militar de un país en vías de desarrollo actuó de forma mucho más rápida y eficiente que el todopoderoso Facebook, menudos genios.

A pesar de que Sarah contactó tanto con la dirección, como con los equipos de contenido para modificar la gestión de Facebook en Myanmar, los trabajadores de Meta la ignoraron. “Para dejar claras las responsabilidades de OC (Equipo de contenido) en este caso [...], el equipo hizo exactamente lo que se suponía que tenía que hacer. Este contenido, a primera vista, no infringía nuestras directrices” rezaba un email enviado a todos los trabajadores del OC. Pero Sarah no estaba de acuerdo. Myanmar era un polvorín que lidiaba con incitaciones al odio, noticias falsas y violencia callejera, en medio de un complejo proceso de transición democrática. Para millones de birmanos, Facebook era internet, mientras que la empresa solo tenía un hablante de birmano en su equipo. Además, este hombre ni siquiera pertenecía a la plantilla y él solito debía enfrentarse a todas las publicaciones de un país entero. De hecho, Facebook ni siquiera tenía publicadas sus normas en birmano, por lo que los usuarios de la plataforma en Myanmar no sabían lo que podía y no podían hacer. Y por si esto fuera poco, Myanmar era uno de los pocos países que no funcionaba con Unicode, el estándar universal de codificación de caracteres en los ordenadores. Como resultado, si estabas en Myanmar podías escribir publicaciones en Facebook y leerlas en caracteres birmanos reconocibles, pero para cualquiera fuera del país, las letras no eran más que un batiburrillo ilegible. ¿Cómo se modera un contenido que no se puede leer? Los responsables del problema eran muy conscientes de ello y llevaban más de un año tratando de avisar del problema, pero Myanmar no era ninguna prioridad por lo que no se hizo nada. Solo necesitaban que alguien con poder dentro de la cúpula de Meta asignase unos cuantos ingenieros para la tarea, pero nadie movió un dedo. “Nos encantaría darle prioridad, pero no creo que podamos justificarlo teniendo en cuenta todos los asuntos que tenemos en marcha” le dijeron a Sarah. En cambio, no hubo ningún problema para crear enormes equipos de ingenieros que desarrollaron la herramienta de Facebook para censurar el contenido que exigía el gobierno chino. Ante semejante situación, Sarah decidió, junto a su equipo, redactar e imprimir una serie de octavillas con indicaciones sobre cómo denunciar contenido cuestionable en la plataforma. La gigantesca empresa digital haciendo comunicados en papel para todo un país, parece un chiste pero es simple y llanamente la realidad. No obstante, como Myanmar seguía sin tener prioridad en la región, estos folletos no fueron repartidos. Ni con tecnología de siglos pasados pudo Sarah completar su loable misión.

Campo de refugiados rohinyás exilados de Myanmar en Bangladés (Fuente: BBC)

La sorpresa llegó en 2015, cuando el equipo de Sarah empezó a notar que los usuarios estaban utilizando aplicaciones no oficiales de Facebook que no tenían la función de “Reportar contenido”; es decir, que no podían denunciar las publicaciones por falsas o por incitar al odio. Esto explicaba sobradamente por qué la junta militar y varios activistas habían estado tanto tiempo denunciando la difusión de discursos de odio por las redes de Myanmar, ¡Los propios usuarios no tenían forma de impedirlo! Además, esto también explicaba porque el equipo de contenido había tenido dificultades para catalogar de inadecuadas diversas publicaciones. Obvio que no lo estaban haciendo, los usuarios no podían reportar las publicaciones. Por si esto no fuera poco, en 2015 surgió otro problema. A pesar de que Facebook había duplicado su plantilla de trabajadores que hablaban birmano (de 1 trabajador a 2) el equipo de Sarah empezó a notar que uno de ellos estaba permitiendo que una gran cantidad de contenido racista llegara a la página. Estaba autorizando que apareciera un insulto muy ofensivo para los musulmanes, kalar, y defendiendo su uso incluso en publicaciones que llamaban al derramamiento de sangre, y eliminaba las publicaciones de grupos de sociedad civil y activistas por la paz. Sarah y su equipo, junto a otros trabajadores de Facebook, trataron de que se prohibiera la palabra kalar en las publicaciones, pero los moderadores se negaron. Años después, en un acto vergonzoso por lo tardío, Facebook prohibió el insulto.

Tras agotar todas las opciones dentro de Facebook, Sarah y su equipo decidieron realizar reuniones clandestinas con organizaciones no gubernamentales (ONG) de Myanmar que monitorizaban lo que se publicaba en Facebook. De esta forma, Sarah podría defender su posición internamente en la empresa. Llegaron a crear grupos secretos en la plataforma para que Sarah y su equipo pudiesen comunicarse con las organizaciones. Ministros del Gobierno difundían discursos de odio y explicaban cómo iban a asegurarse de que los musulmanes no votaran en las siguiente elecciones, candidatos avalados por la junta incitaban a quemar mezquitas hasta sus cimientos, todo ello a través de Facebook. La situación se fue tensando a medida que Myanmar se encaminaba hacia sus primeras elecciones libres en décadas, convocadas para noviembre de 2015. Un mes antes de las elecciones, las organizaciones no gubernamentales con las que trabajaba Sarah, le comunicaron que los perfiles de Facebook de candidatos liberales contrarios a la junta militar estaban siendo eliminados de la plataforma en bloque. Al mismo tiempo, la junta empezó a detener a los miembros de las ONG que trabajaban con Sarah. Por suerte, y gracias al trabajo de Sarah y su equipo, las elecciones transcurrieron de forma pacífica, con solo algunos incidentes aislados en los días previos. La Liga Nacional para la Democracia tuvo una victoria aplastante frente a la junta militar, pero en 2016 todavía no parecía claro que la junta fuese a respetar los resultados electorales. De hecho, tras las elecciones, los discursos de odio y las noticias falsas seguían estando muchos más presentes en el Facebook de Myanmar que en cualquier otro lugar del mundo.

Tras las elecciones, el equipo de seguridad de Facebook registró un patrón generalizado de pirateo y apropiación de cuentas en Myanmar. Un grupo secreto de casi 600 individuos se dedicaba a planificar y compartir información para llevar a cabo ciberataques contra páginas y usuarios verificados. Y no solo eso, dicho grupo también se apropiaba de las cuentas verificadas con miles de seguidores de usuarios de Facebook para compartir fotos escabrosas, noticias falsas, memes incendiarios y propaganda, haciéndose pasar por estos usuarios. El miedo y el odio se extendieron por la plataforma con una velocidad apabullante. Y, por supuesto, Facebook priorizaba todo este contenido ya que generaba muchas más interacciones. No solo no eliminaban las publicaciones de incitación al odio, sino que el algoritmo las promocionaba.

Manifestación a favor de la Liga Nacional para la Democracia en Myanmar en 2015 (Fuente: El País)

Sabían lo que estaba ocurriendo en Myanmar, pero no hacían nada al respecto. En 2017 se hizo viral una noticia falsa de que el presidente del país, el primero democráticamente electo en décadas, iba a dimitir. De nuevo, el equipo de Sarah solicitó la eliminación de estas publicaciones, pero el Equipo de Contenidos se echó las manos a la cabeza, ya que esas publicaciones, supuestamente, no estaban infringiendo ninguna ley. Uno de los integrantes del equipo de Sarah en Myanmar respondió: “Mucha gente cree que los militares o alguien está intentando erosionar la democracia en Myanmar. Hemos identificado centenares de cuentas que tratan de desestabilizar la situación. El equipo de operaciones de seguridad está ahora mismo revisándolas […] ¿Vamos a dejar que utilicen nuestro servicio para desestabilizar un país?” Al parecer parecía que si lo iban a permitir. Lo impensable acabó por suceder. A finales de agosto, los militares lanzaron una campaña de violencia contra la minoría musulmana que las Naciones Unidas calificaron a posteriori de genocidio y crímenes contra la humanidad. Al menos 10.000 personas murieron asesinadas. Las entrevistas a los más de 800 testigos presenciales que relata el informe de Naciones Unidas dejan los pelos de punta: “Mataron a niños delante de sus padres, y hubo niñas víctimas de violencia sexual [...]. Se perpetraron violaciones y otros tipos de violencia sexual a gran escala [...]. En algunos casos, hasta cuarenta mujeres o niñas fueron violadas en grupo a la vez [...]. Las violaciones se llevaban a cabo en muchas ocasiones en espacios públicos y delante de sus familias o de su comunidad, para mayor humillación y trauma. Hubo madres a las que se violó en grupo delante de sus hijos pequeños, los cuales sufrieron heridas de gravedad y en algunos casos murieron [...]. Mujeres y niñas fueron sistemáticamente secuestradas, detenidas y violadas en recintos militares y policiales, en situaciones equiparables a la esclavitud sexual. Las víctimas sufrieron heridas de gravedad antes y durante las violaciones, y a menudo quedaban marcadas con mordeduras profundas. Sufrieron heridas graves en los órganos sexuales, en algunos casos por violaciones con cuchillos y palos. Muchas de las víctimas fueron asesinadas o murieron a consecuencia de las heridas [...] Otros murieron en incendios provocados, quemados vivos en sus propios hogares, sobre todo personas mayores, discapacitados y niños muy pequeños, incapacitados para escapar”.

Más de 700.000 musulmanes huyeron del país. Y lo que el mundo sabría después es que los militares habían puesto en marcha una operación a gran escala (con al menos 700 personas) para propagar el odio y la desinformación en Facebook. El periodista Paul Mozur de el New York Times contactó con fuentes de la operación militar secreta que le desvelaron cómo crearon y se apropiaron de cuentas verificadas con una gran cantidad de seguidores (cuentas de fans de estrellas del pop y famosos, páginas dedicadas a héroes militares…) y las utilizaron para realizar publicaciones falsas e incendiarias. “Cuentas trol operadas por militares ayudaron a difundir contenido, acallar a los críticos y avivar discusiones entre quienes comentaban las noticias para crispar a la población”. Tal como señaló Mozur: “Estas acciones del Ejército birmano son uno de los ejemplos más claros de cómo un Gobierno autoritario aprovecha las redes sociales contra sus propios ciudadanos”. ¿La respuesta de Facebook? eliminar unas pocas de esas cuentas y no investigar nada más, ni siquiera la relación con los militares. ¿Cuál fue el papel de Facebook en todo esto? El informe de Naciones Unidas dedica más de 20 páginas al rol crucial que desempeñó Facebook en la difusión del odio. Como por ejemplo, la paupérrima moderación de contenidos de Facebook en Myanmar (recordemos que había un solo moderador para todo un país), el hecho de que el birmano no puede representarse en Unicode, la falta de un sistema claro para informar y reportar los discursos de odio y la alarmante ausencia de respuesta por parte de Facebook cuando estos contenidos son denunciados. Aunque Facebook afirmó no poder proporcionar datos sobre los discursos de odio en su plataforma, algo imprescindible para evaluar la situación, lo cierto es que guardaba un registro completo sobre este tema. Únicamente se estaban guardando las espaldas. De hecho, el propio equipo de contenidos de Facebook había escrito un informe que señalaba que 45 de las 100 cuentas de incitación al odio más activas del sudeste asiático estaban en Myanmar.

Myanmar hubiera estado mucho mejor si Facebook no hubiera llegado nunca allí. No es que la empresa tuviese inquina hacia los musulmanes del país, ni por falta de dinero, la conclusión de Sarah es que a la cúpula de Facebook le importaba una mierda. Todas las personas afectadas no les importaban lo más mínimo. No le quitaban el sueño, y no ofrecieron ningún otro motivo para excusarse de haber orquestado un genocidio. Valientes hijos de puta.

Artículo basado en: